小巧的Ceva-NeuPro-Nano NPU带来了超低功耗与最佳性能的优化平衡,可在消费、工业和通用 AIoT 产品中高效执行 TinyML 工作负载

用于 Ceva-NeuPro NPU 系列的 Ceva-NeuPro Studio完善了 AI SDK,支持包括TensorFlow Lite for Microcontrollers和 microTVM的开放式 AI 框架,可加快开发 TinyML 应用

Ceva 凭借在物联网连接方面的市场领导地位以及在音频和视觉传感方面的强大专业知识,开发针对嵌入式设备的优化 NPU,帮助半导体企业和 OEM厂商发挥边缘人工智能的潜力

帮助智能边缘设备更可靠、更高效地连接、感知和推断数据的全球领先半导体产品和软件IP授权许可厂商Ceva公司(纳斯达克股票代码:CEVA) 宣布推出Ceva-NeuPro-Nano NPU以扩展其Ceva-NeuPro Edge AI NPU产品系列。这些自给自足的高效NPU可为半导体企业和OEM厂商提供所需的功耗、性能和成本效益,以便在用于消费、工业和通用 AIoT 产品的SoC 中集成TinyML模型。

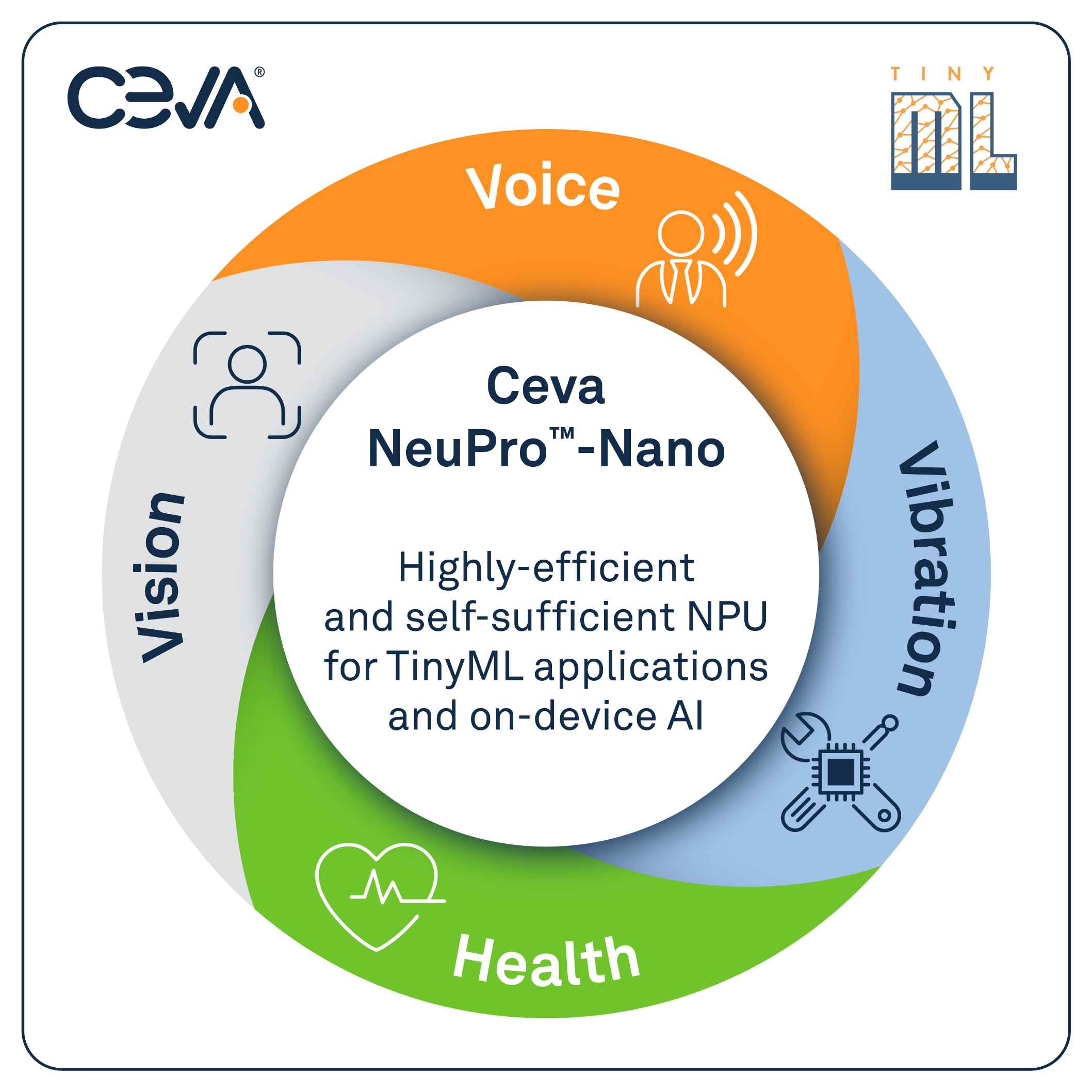

TinyML是指在低功耗、资源受限的设备上部署机器学习模型,从而将人工智能引入物联网 (IoT)。物联网设备对高效、专业的人工智能解决方案的需求日益增加,推动了TinyML市场快速增长。根据研究机构ABI Research预测,到 2030 年,超过40% 的TinyML出货量将采用专用 TinyML 硬件,而非由通用MCU驱动。Ceva-NeuPro-Nano NPU解决了TinyML所面临的特定性能难题,以实现无处不在和经济实用的人工智能,广泛应用于消费和工业物联网应用中的语音、视觉、预测性维护和健康感知等领域。

新型 Ceva-NeuPro-Nano 嵌入式AI NPU架构完全可编程,可高效执行神经网络、特征提取、控制代码和 DSP 代码,并支持最先进的机器学习数据类型和运算符,包括原生变换器计算、稀疏性加速和快速量化。与需要结合CPU或DSP并且基于 AI 加速器架构的现有TinyML 工作负载处理器解决方案相比,这种优化的自给自足架构使得Ceva-NeuPro-Nano NPU具有更高的能效、更小的硅片尺寸以及更佳性能。此外,Ceva-NetSqueeze AI压缩技术可直接处理压缩模型权重,省去中间的解压缩阶段,这减少了80%的Ceva-NeuPro-Nano NPU内存占用,从而解决了阻碍AIoT处理器广泛应用的关键瓶颈问题。

Ceva副总裁兼传感器和音频业务部门总经理Chad Lucien表示:“Ceva-NeuPro-Nano将TinyML应用集成到低功耗物联网SoC和MCU中,并且以我们的企业战略为基础,通过先进的连接、传感和推理能力为智能边缘设备赋能,为企业开创了难能可贵的机会。Ceva-NeuPro-Nano系列NPU使得更多公司能够将人工智能带入边缘应用,从而制造具有先进功能集的智能物联网设备,为客户创造更多的价值。我们在无线物联网连接方面具有行业领先地位,在音频和视觉传感方面亦拥有强大专业技术,具备独一无二的市场条件,能够帮助客户发挥TinyML的巨大潜力,实现创新的解决方案,从而增强用户体验、提高效率,并为建设更智能、更互联的世界做出贡献。”

ABI Research 行业分析师 Paul Schell 表示:“对于在智能边缘物联网设备上实现人工智能,Ceva-NeuPro-Nano可以满足电池供电设备对功耗、性能和成本的要求,实现语音、视觉和传感用例在广泛终端市场的始终在线应用,令人刮目相看。从 TWS 耳机、耳塞、可穿戴设备和智能扬声器到工业传感器、智能电器、家居自动化设备、摄像头等,Ceva-NeuPro-Nano可以在能源受限的 AIoT 设备中实施 TinyML。”

Ceva-NeuPro-Nano NPU提供两款配置,包括配备32个int8 MAC的Ceva-NPN32和配备64个int8 MAC的Ceva-NPN64,两种配置都通过Ceva-NetSqueeze获得直接处理压缩模型权重功能。Ceva-NPN32 针对语音、音频、物品检测和异常检测用例的大多数 TinyML工作负载进行了高度优化;Ceva-NPN64则利用权重稀疏性、更大内存带宽、更多MAC和4位权重支持提供2倍性能加速,从而提供更强大的性能,在设备上实现更复杂的人工智能用例 (如物品分类、人脸检测、语音识别和健康监测等) 。

这些NPU随附完整的人工智能SDK - Ceva-NeuPro Studio,这是为整个Ceva-NeuPro NPU系列提供一套通用工具的统一人工智能堆栈,支持包括TensorFlow Lite for Microcontrollers (TFLM) 和 microTVM (µTVM)的开放式人工智能框架。

Ceva-NeuPro-Nano 主要特性

灵活的可扩展NPU 架构

完全可编程,高效执行神经网络、特征提取、控制代码和 DSP 代码

设计具备可扩展性能,满足广泛用例需求

具有每周期最多 64 个 int8 MAC的MAC 配置

面向未来的架构,支持最先进的 ML 数据类型和运算符

支持 4 位至 32 位整数

原生变换器计算

利用先进的机制为所有用例提供终极 ML 性能

稀疏性加速

非线性激活类型加速

快速量化

超低内存需求边缘 NPU

用于NN计算、特征提取、控制代码和DSP代码的高效单核设计,可让这些计算密集型任务省去配套MCU

通过 Ceva-NetSqueeze 直接处理压缩模型权重,省去中间的解压缩阶段,最多可减少 80% 的内存占用

通过创新能源优化技术实现超低能耗

自动化的即时能源调整

通过使用权重稀疏性加速对计算进行提炼,大幅降低能耗和带宽需求

易于使用的完备人工智能 SDK

Ceva-NeuPro Studio为所有Ceva-NeuPro NPU (从全新Ceva-NeuPro-Nano到功能强大的Ceva-NeuPro-M) 提供统一的人工智能堆栈,具有简便的点击运行使用体验

加速软件的开发和部署,从而缩短产品上市时间

经过优化,可与包括 TFLM 和 µTVM 在内的领先开放式人工智能推理框架无缝协作

Model Zoo包含预训练和优化的TinyML 模型,涵盖语音、视觉和传感用例

灵活适应新的模型、应用和市场需求

全面的优化运行时间程序库和现成的特定应用软件组合

供货

Ceva现在提供Ceva-NeuPro-Nano NPU授权许可,如要了解更多信息,请访问公司网页:

https://www.ceva-ip.com/product/ceva-neupro-nano/

关于Ceva公司

Ceva热忱地为智能边缘带来全新的创新水平。我们的无线通信、感知和边缘AI技术是现今一些先进智能边缘产品的核心。我们拥有更可靠、更高效地连接、感知和推理数据的广泛IP 组合,包括用于蓝牙连接、Wi-Fi、 UWB 和5G 平台 IP,实现无处不在的强大通信;以至可扩展的边缘人工智能 NPU IP、 传感器融合处理器和提升设备智能的嵌入式应用软件。我们的差异化解决方案在极小的硅片尺寸内以超低功耗提供卓越性能。我们的目标简单:为业界提供半导体产品和软件 IP,创建更智能、更安全和更紧密互连的世界。今天,Ceva 正在努力践行这一理念,支持全球超过 170 亿个创新性智能边缘产品,涵盖从人工智能智能手表、物联网设备和可穿戴设备,直到自动驾驶汽车和 5G 移动网络。

Ceva总部位于美国马里兰州罗克维尔,公司遍布世界各地的运营机构为全球客户群提供有力支持。我们的员工包括各专业领域的顶尖专家,能够持续解决最复杂的设计难题,帮助客户将创新的智能边缘产品推向市场。

Ceva: 助力智能边缘

关注Ceva微信订阅号,请搜寻 “CEVA-IP”。